Здравствуйте, bazis1, Вы писали:

B>Здравствуйте, bnk, Вы писали:

bnk>>Понял. Я переключился в моем случае на structured outputs (но это не про редактор, немного другой случай, намного проще)

bnk>>Проблема с текстом была в том что несмотря на инструкции, модель им (иногда) не следовала. structured output фиксирует схему генерируемого моделью json, и гораздо практичнее для использования кодом, ничего не нужно парсить.

B>Ха! Если бы все было так просто. Проблема в том, что у LLM нет интуиции. Если повесить на нее структурные ограничения с API или схемой, то, по сути, за каждый токен будут драться две подсети: одна, пытающаяся вписаться в формат, и другая, пытающася выдать смысловой результат.

B>В итоге, на выходе часто получается структурно корректное сообщение, абсолютно бесполезное для пользователя. Как в анекдоте про программиста и воздушный шар.

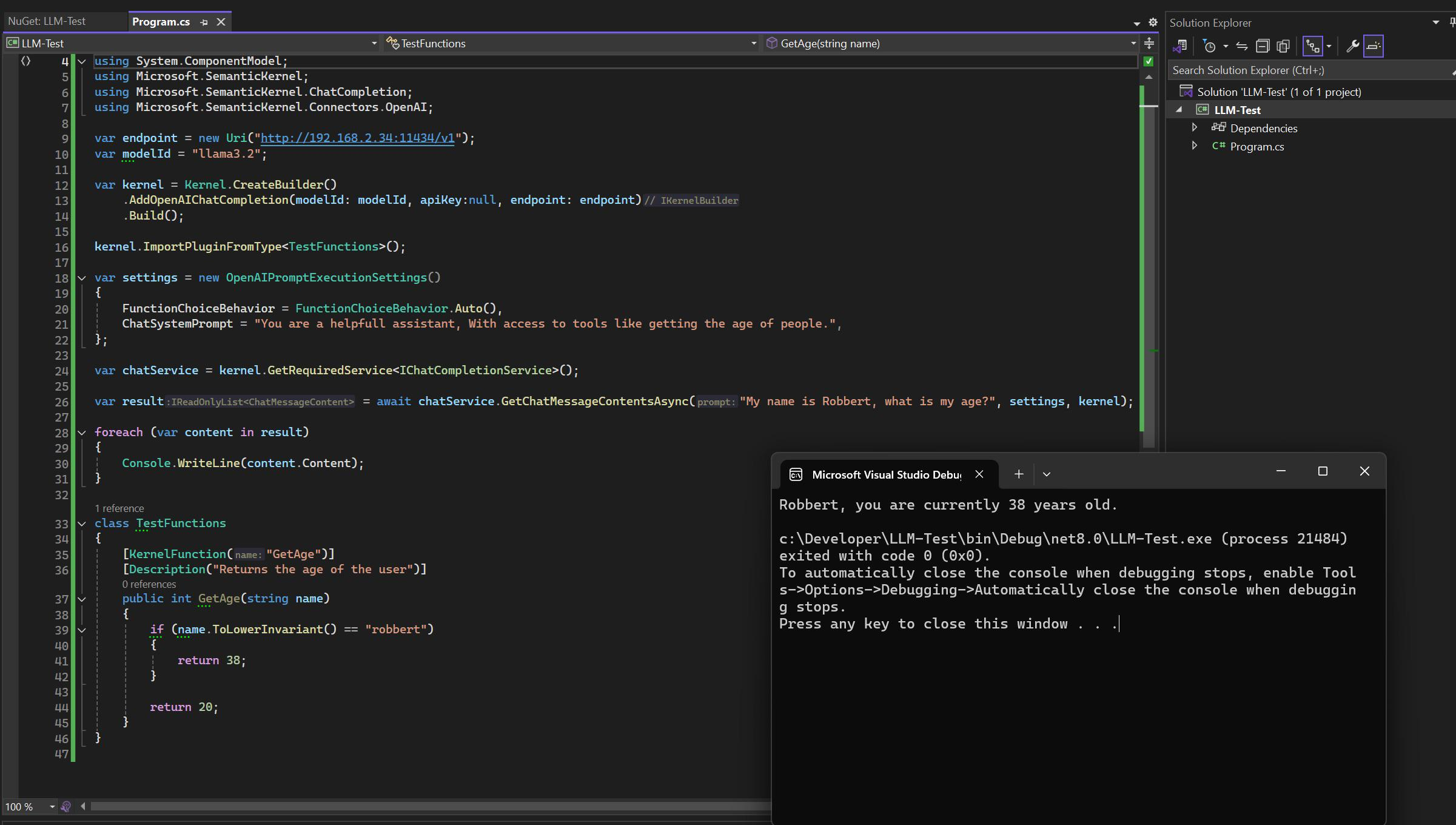

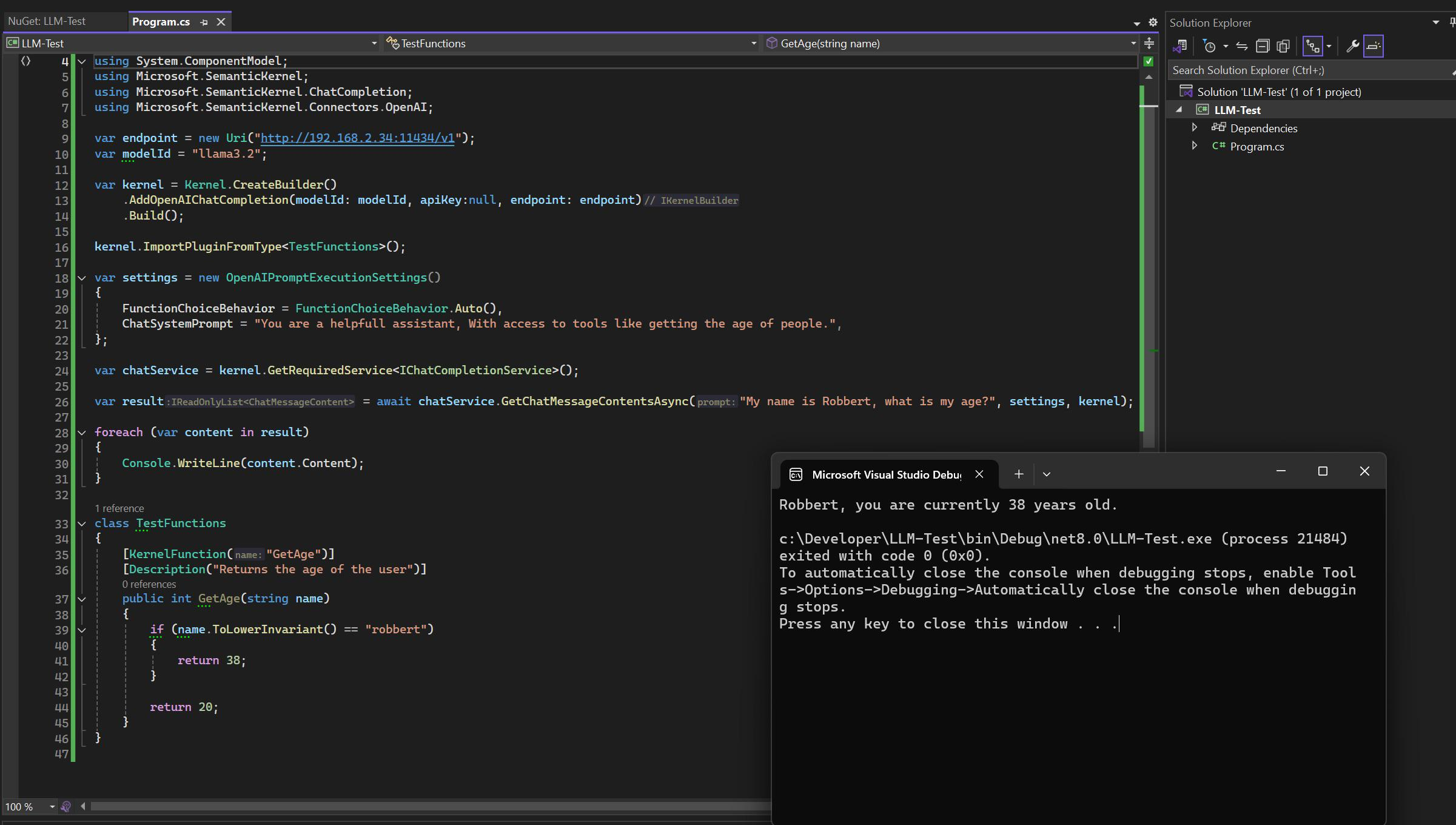

Я имел в виду построение (собирание) промпта. Вручную это делать как-то по кустарному, как мне кажется. Вот пример ниже, чтобы проиллюстрировать что я имел в виду

| | здесь |

| |  |

| | |

https://www.reddit.com/r/LocalLLaMA/comments/1ghaz6q/just_tried_out_semantic_kernel_in_net/#lightbox